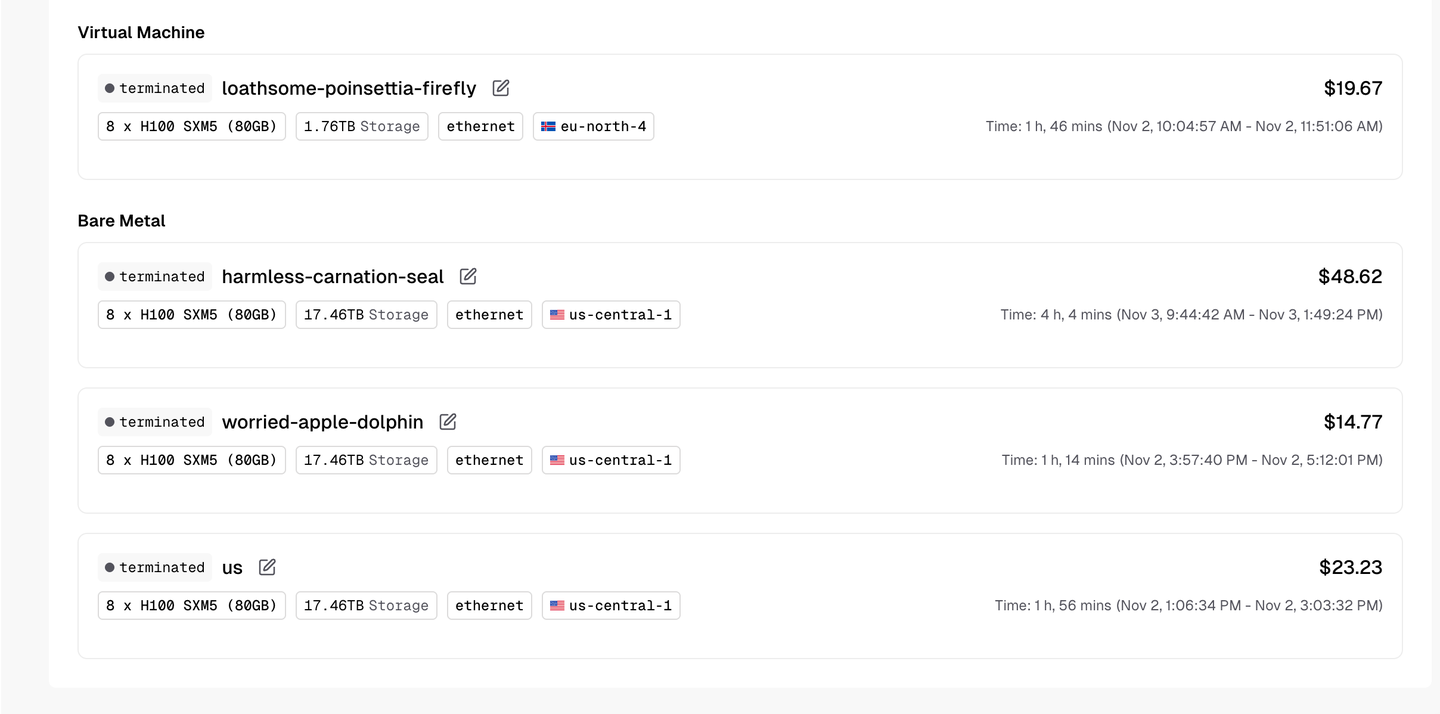

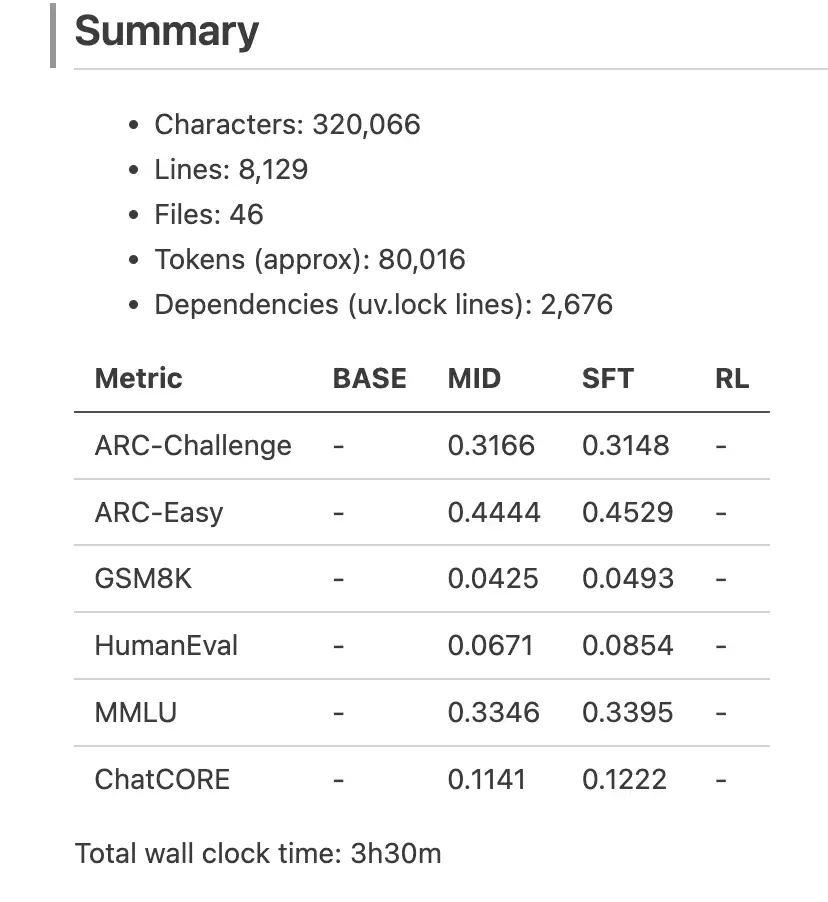

花费了 8w 个 token, 110$的 gpu 服务器成本(一般时间花在 debug 上,一半时间训练)

感受是 gpu 价格及其贵,代码出现 1 个 bug = 10min debug -> 至少 1.2$花销

bug 出现频率高: python 容易写出语法/变量名错误,超参数填的的不对会导致 gpu 计算错误,cuda 和 pytorch 版本问题也会导致出错

总结就是:

1. 犯错的代价是严重的,务必用小批量数据测试代码是否写的正确

2. ai 基建大概率不是泡沫

以上 gpu 是租的便宜的小厂商的,主流云服务价格翻倍