以下是 Ollama 的一些关键特性和功能:

主要功能

[ol]

模型管理:

部署选项:

API 和 SDK:

扩展性和集成:

监控和日志:

[/ol]

应用场景

优势

1.下载 安装ollama

百度网盘:https://pan.baidu.com/s/17RrMHC4VOw-sFtk8xl8Gtg?pwd=1vxc

ollama网站:https://ollama.com/download

github:https://github.com/ollama/ollama/releases

1.点击Install

2.安装后窗口自动关闭

3.按WIN+R键,打开“运行”对话框,输入 cmd ,按回车键

在命令提示符中输入 ollama -v 出现版本号,安装成功

4.修改模型安装位置

按WIN+R键,打开“运行”对话框,输入 sysdm.cpl ,按回车键

按顺序点击 高级->环境变量->新建

在变量名中输入 OLLAMA_MODELS

在变量值中输入 存放模型的位置 我这里放在 D盘的ollama文件夹下

继续按顺序点击 确定->确定->确定

让后关闭所有的命令提示符

2.下载模型

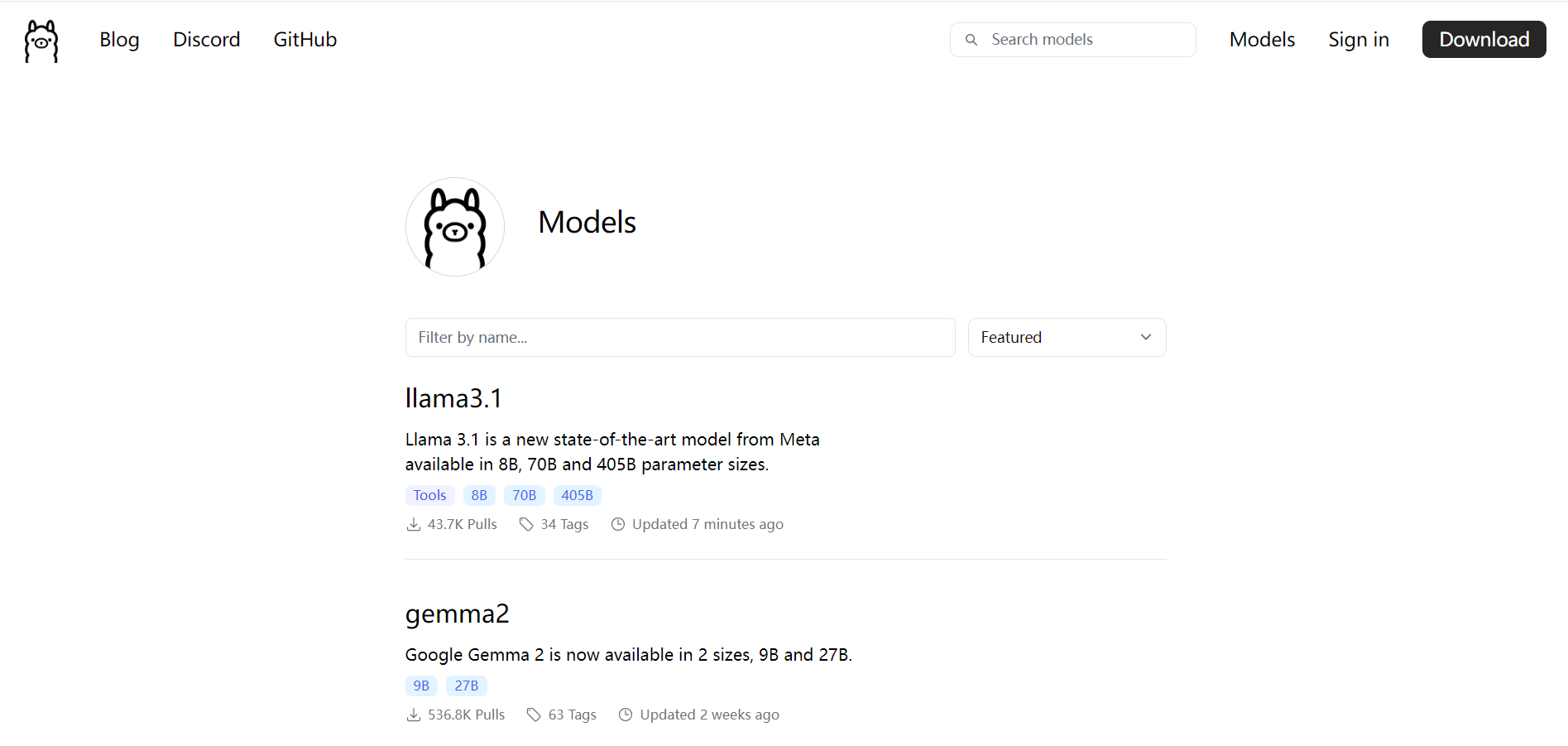

模型网站:https://ollama.com/library

[ol]

[/ol]

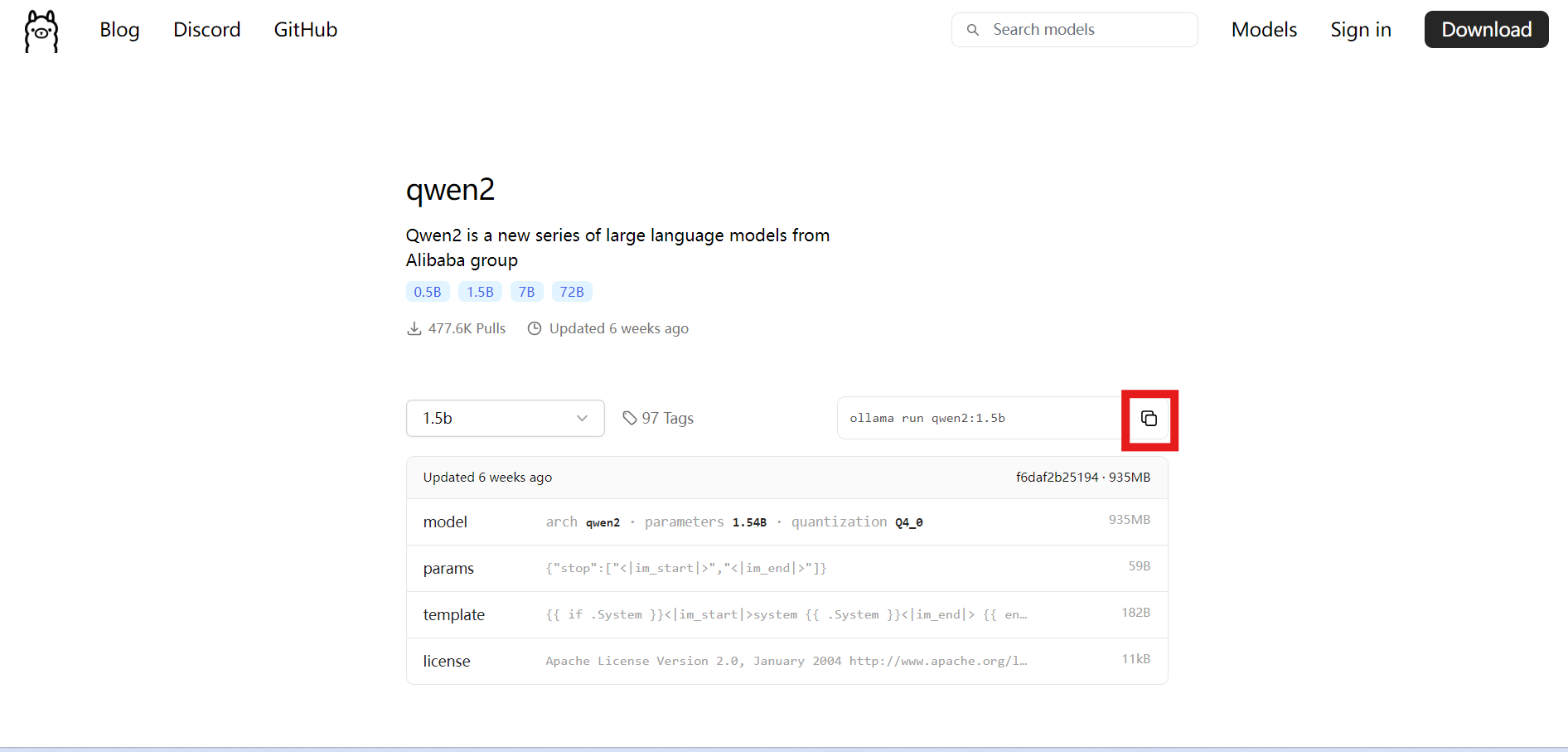

2.选择模型(以通义千问为例)

这里的 "b" 是 "billion"(十亿)的缩写,因此这些数字代表了模型参数的数量级。1b的意思是该模型拥有约 10 亿个参数。

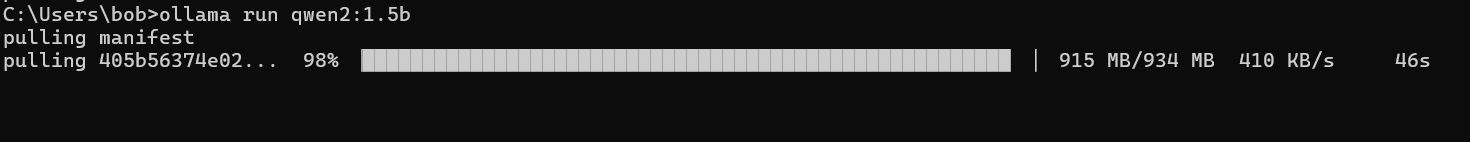

3.复制命令,并在命令提示符中粘贴,ollama会自动下载模型 如果需要安装UI页面的可以先去第3板块,下载模型比较慢

4.当出现success时,代表模型下载完成,可以使用了。

3.安装ollama-webui(可选)

如果你觉得每次在命令提示符中使用,没有UI页面,可以安装ollama-webui

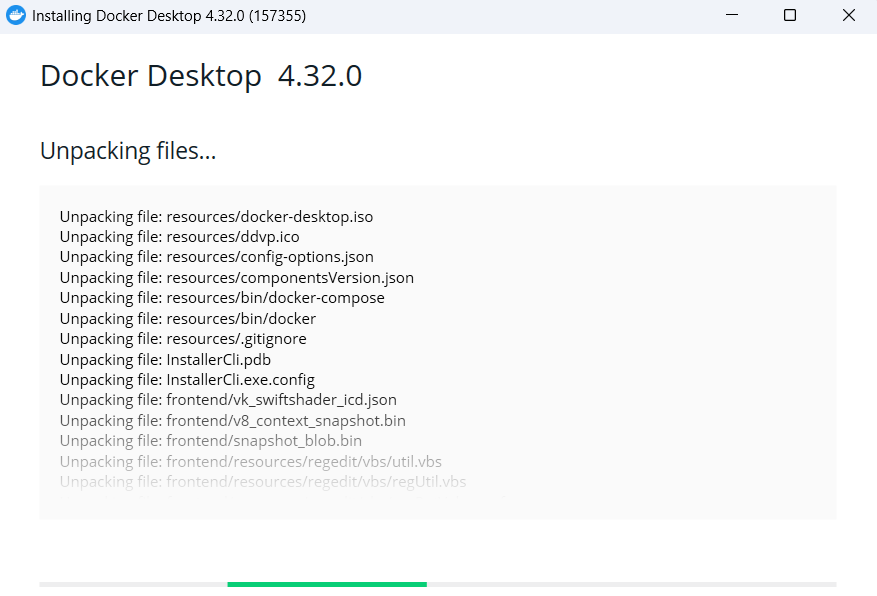

1.下载Docker

Doker:https://docs.docker.com/desktop/install/windows-install/(可能有些小伙伴打不开)

百度网盘:https://pan.baidu.com/s/146BfhBLTkItM5x9qWu4fbg?pwd=474u

2.安装Docker

3.注意!!非常重要,特别是对不看提示一直点的人说

这里会重启你的电脑!请保存好你的重要文件!

这里会重启你的电脑!请保存好你的重要文件!

这里会重启你的电脑!请保存好你的重要文件!

重要的事情说三遍!

4.在命令提示符中输入 docker -v 出现版本号,安装成功

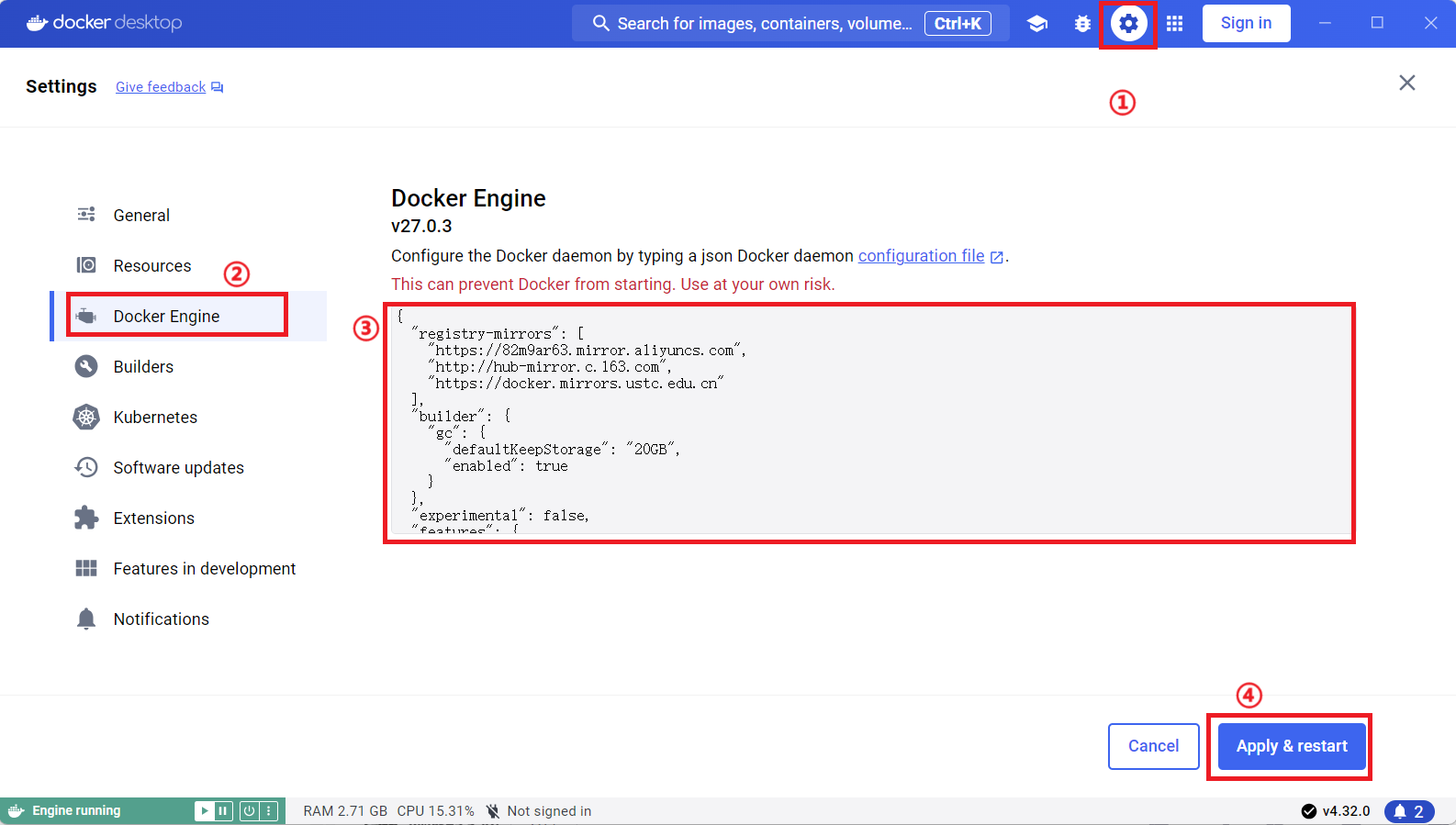

5.打开Docker 更换国内镜像源

按顺序点击 齿轮->Docker Engine

在输入框中粘贴镜像源

镜像源:

{

"registry-mirrors": [

"https://82m9ar63.mirror.aliyuncs.com",

"http://hub-mirror.c.163.com",

"https://docker.mirrors.ustc.edu.cn"

],

"builder": {

"gc": {

"defaultKeepStorage": "20GB",

"enabled": true

}

},

"experimental": false,

"features": {

"buildkit": true

}

}

点击 Apply & restart

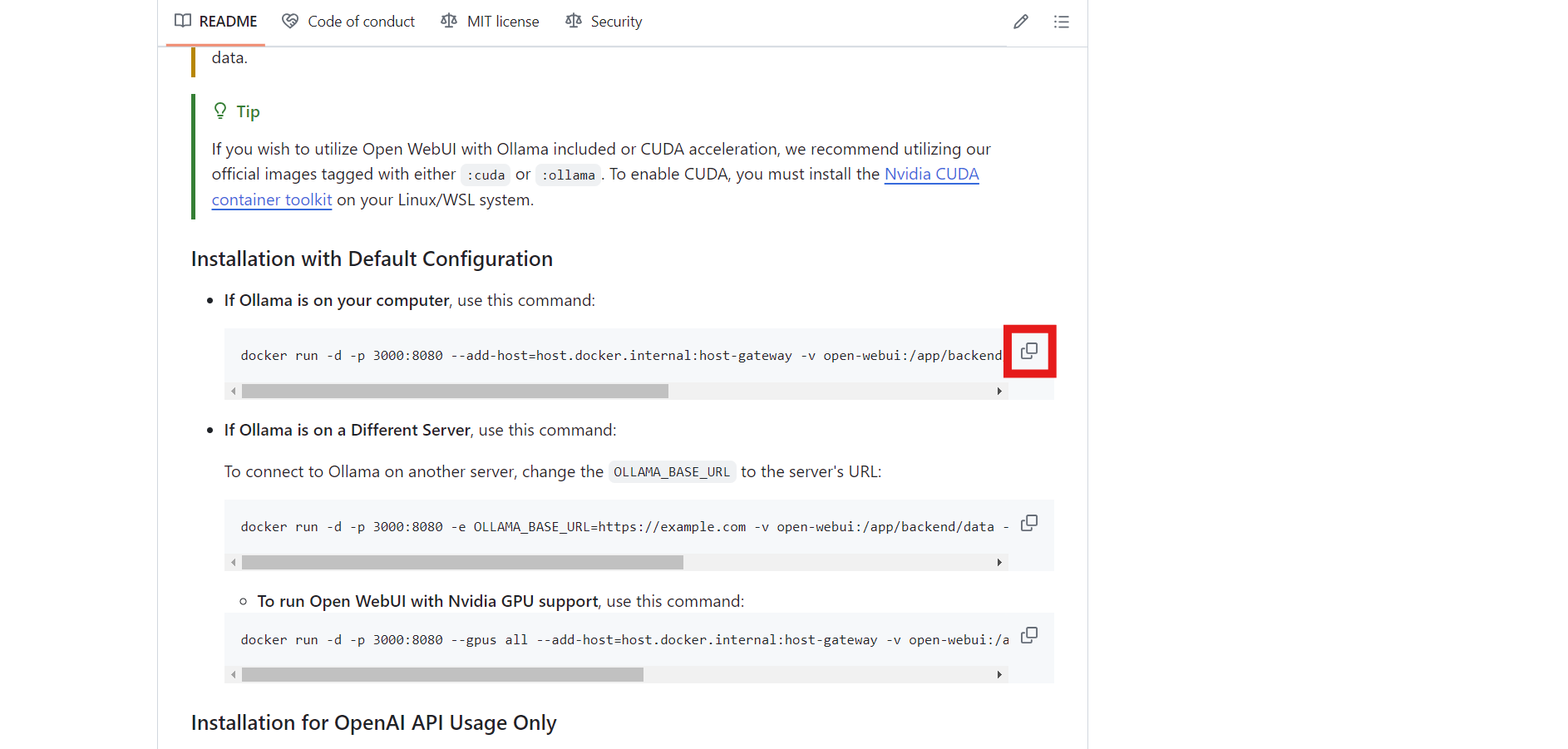

6.安装ollama-webui

github:https://github.com/open-webui/open-webui

往下,找到 Installation with Default Configuration

复制命令,到命令提示符,粘贴

```

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

```

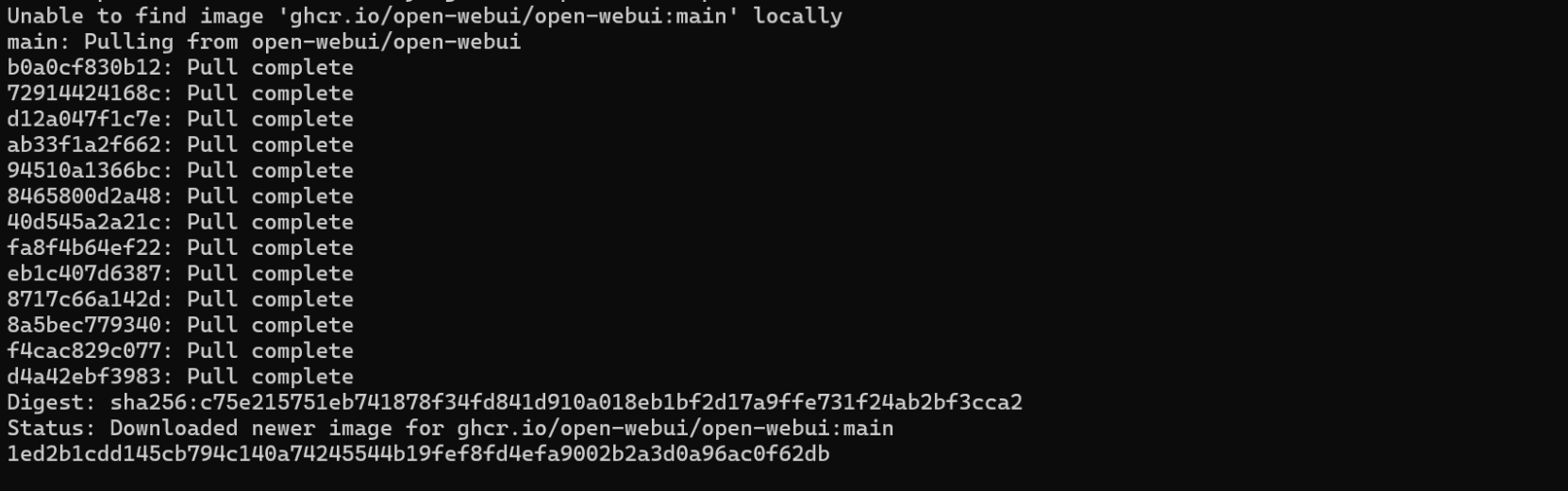

命令执行完成,安装完成

7.使用ollama-webui

在浏览器打开http://localhost:3000/

输入邮箱和密码,随便填

8.语言改为中文

按顺序点击 头像->Settings

在红框位置展开,往下拉,改成中文

4.ollama+python(可选)

1.打开python 如何下载python这里就不演示了

2.在命令提示符中输入 pip install ollama

只要出现 successful 表示安装成功,前面的错误不用理会

3.测试代码

import ollama

response = ollama.chat(model='qwen2:1.5b', messages=[

{

'role': 'user',

'content': '你好',

},

])

print(response['message']['content'])

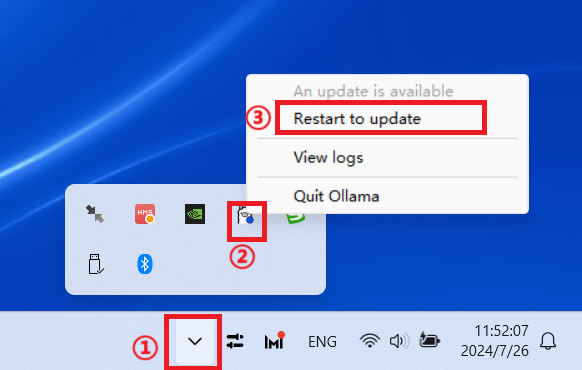

更新ollama

1.鼠标左键小箭头

2.鼠标右键羊驼

3.鼠标左键 Restart to update

更多ollama命令

可用命令:

[table]

[tr]

[td]命令[/td]

[td]解释[/td]

[/tr]

[tr]

[td]serve