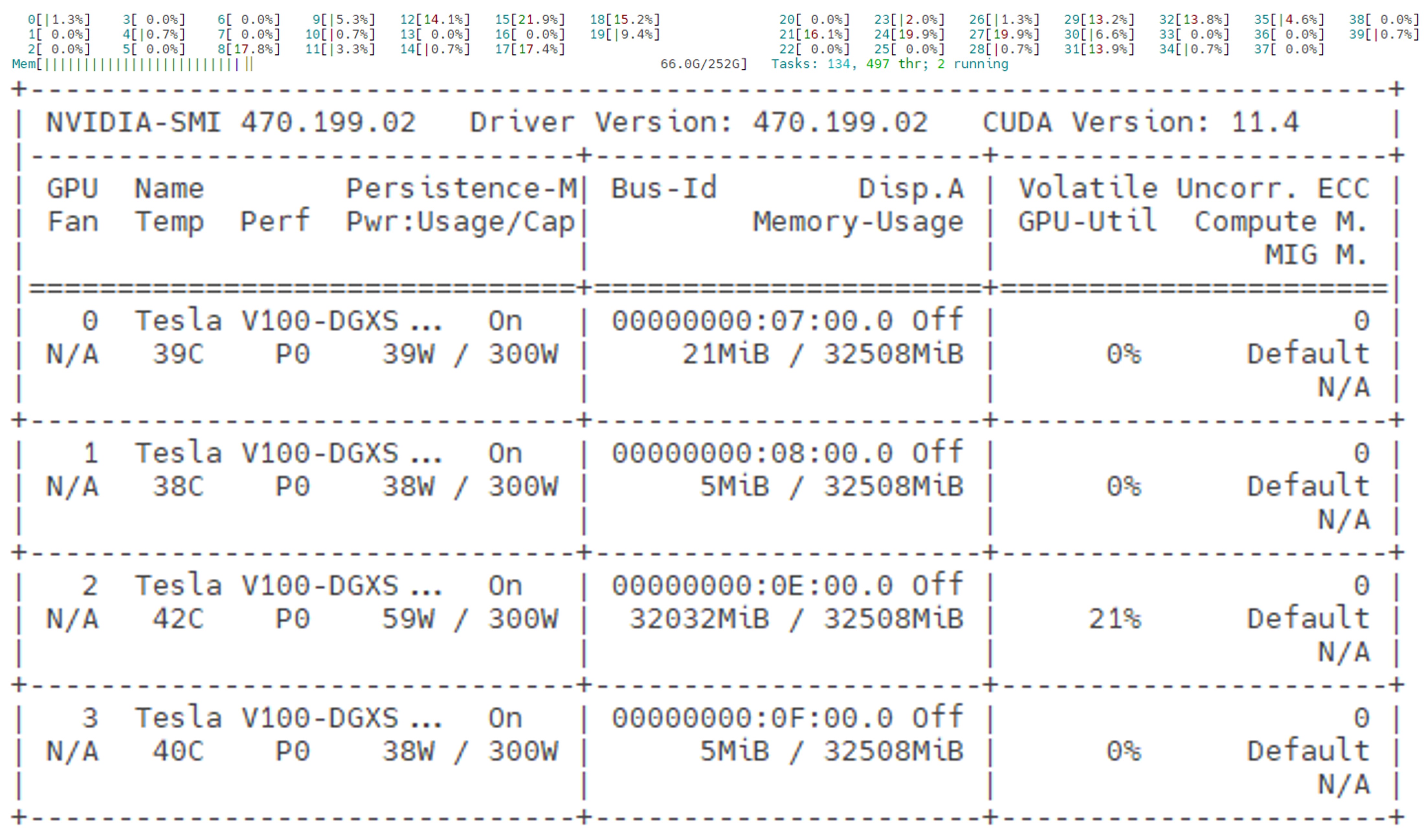

“跑下大模型玩一玩”用 llama.cpp 就可以了,内存 32G 可以轻松跑起来 Q8 量化的 llama2 13B 版本,连 GPU 都不需要。 “跑大模型训练数据”,起码得 4 块 V100 和 256G 内存才能顺畅的调试。 想调试模型,可以参考我的服务器配置,自己组一个:

配置升级的选择: 预算低,无动手能力: 4060Ti / 2080 魔改 22GB 预算最低,有软件+硬件方面的动手能力: P40 24GB (性能不是很强,但显存带宽还不错,694.3 GB/s ) 高预算: 双 3090 (对主板/供电要求很高,还需要一个房间来放,因为很吵) 另类选择: 买一台 Mac Studio M2 Ultra 192GB 内存 只能玩 llama.cpp ,生态差了点,训练不行

如果你的电脑有 8GB 以上的内存,我建议不升级 先用 llama.cpp 玩一下 4bit 量化的模型 如果觉得 llama.cpp 用起来麻烦,用这个: https://github.com/LostRuins/koboldcpp 或者这个: https://lmstudio.ai/